Dia Internacional da Mulher: a Inteligência Artificial (IA) é machista?

Podemos considerar três formas para IA ser menos preconceituosa e enviesada: dados, algoritmos e pessoas; entenda

A resposta mais simples é “não”. Mas a gente sabe que a complexidade e a contradição são inerentes às nossas relações, às culturas e à nossa sociedade, independentemente da tecnologia. Por isso mesmo, uma resposta mais completa exige que analisemos, mesmo que superficialmente, as origens de uma série de vieses que a inteligência artificial reproduz, e um deles o viés de gênero.

Sendo assim, já podemos dizer de bate-pronto que a IA não é preconceituosa por natureza. O preconceito que ela possui não vem do nada, mas sim de padrões que perpetuamos em nossas sociedades. Por isso não é que a IA seja neutra, ou que a tecnologia seja neutra, porque não é. Porque tecnologia é um desenvolvimento humano, e nós, seres humanos, somos recheados de vieses, sejam aqueles construídos socialmente ou cognitivos, que claramente recebem influência do nosso meio, cultura e sociedade. Assim como temos uma série de pré-conceitos.

No meio dessa contradição, a IA acaba por internalizar nossos vieses e preconceitos, incluindo o de gênero. Então, talvez pra resumir, “a IA é um espelho de nós mesmos”.

Ao executar programas, que por agora ainda são feitos por seres humanos, e por dar respostas que tem como base dados que também vem dos seres humanos, ela acaba por reproduzir o que somos.

A IA não tem consciência, juízo, moral, valores e ética. Ela simplesmente não entende se os dados de treinamento são objetivos (como a temperatura média da nossa cidade ao longo de anos) ou subjetivos (como a decisão de oferecer um empréstimo a alguém). Por esse motivo, para conseguirmos minimizar esses efeitos enviesados temos que procurar entender quais realidades esses dados usados para treinamento das IAs refletem.

Viés de gênero

Mas antes de falar sobre os dados, vamos entender o que é um viés de gênero e como isso impacta a sociedade na era digital.

Por definição, um viés de gênero é uma suposição ou presunção que, deliberadamente, atribui características a favor ou contra a um gênero em específico. Geralmente os vieses carecem de evidência científica, e muitas vezes quando possuem evidências científicas, estas também podem estar incorretas, afinal a ciência é feita por seres humanos. Um clássico é o Neurossexismo, que perpetuou por anos um viés na neurociência sobre as diferenças entre cérebro de homens e mulheres e que reforçavam estereótipos de gênero prejudiciais, como o de que os cérebro das mulheres são bons em multitarefas e o de homens funcionam em uma tarefa por vez. O termo foi cunhado pela estudiosa feminista Cordelia Fine em um artigo de 2008, e que tem um livro brilhante, de 2011: Delusions of Gender: How Our Minds, Society, and Neurosexism Create Difference. Uma neurocientista cognitiva que também se debruçou no tema foi Gina Rippon, que tem o livro: The Gendered Brain: The new neuroscience that shatters the myth of the female brain. Cito eles por serem reveladores de como a ciência também pode nos manipular. Mas não vem ao caso agora.

Vieses e preconceito

Voltemos aos vieses! A maioria deles estão baseados em crenças inconscientes e conscientes que as pessoas têm sobre os diferentes gêneros, baseando-se em estereótipos socioculturais aprendidos. Como a IA não está isenta de reproduzir viés de gênero em seu código, o que também poderia ser um procedimento questionável, como mostrarei mais adiante, a IA se nutre dos dados que são usados para treiná-la, ou seja, fazê-la aprender, e por isso se trata de processos do que chamamos de Machine Learning (ML), ou aprendizado de máquina.

Dependendo da origem desses dados e de como eles são tratados, catalogados ou rotulados, esses vieses acabam sendo não apenas reproduzidos, como muitas vezes reforçados. Por isso, se a gente pedir pro ChatGPT inventar uma história sobre alguém que ensina crianças ou cuida delas, essa pessoa será uma mulher. Se pedirmos uma história de alguém líder de uma empresa de sucesso, essa pessoa será um homem.

Se os dados refletem a nossa sociedade em parte preconceituosa, patriarcal, machista e misógina, claramente se não houver mulheres suficientes contribuindo no tratamento desses dados, assim como na criação desses modelos, certamente haverão lacunas no conhecimento da IA e programas pouco diversos na forma que entendem e executam os dados, respectivamente. E é por isso que ocorrem esses “erros” de preconceito, já que o que é incorporado ao sistema depende de quem faz isso. Tanto os dados quanto as equipes devem refletir a pluralidade da sociedade.

Nesse dia tão especial, o Dia Internacional da Mulher que é, sobretudo, um marco de luta por direitos humanos, trazer essa pauta para o campo do Big Data e da IA nos revela o tamanho dos desafios da área e de como a luta das mulheres continua e deve se intensificar no digital.

Se para ser inteligente, a revolução digital tem que ser inclusiva, as discussões sobre a regulamentação da IA devem passar pela ética que envolve essas questões. Basta lembrarmos de alguns fatos que reforçam a importância disso. Um dos exemplos que ficou bastante famoso foi a IA de recrutamento da Amazon, que desfavoreceu as inscrições de mulheres em processos seletivos porque a IA foi treinada em dados de currículos de quem já trabalhava na área, que era uma força de trabalho majoritariamente masculina.

Outro caso emblemático pra mim foi a Tay, vocês se lembram dela? Foi um chatbot de IA lançado pela Microsoft no Twitter (hoje X), em 2016. A ideia é que Tay fosse treinada, ou seja, aprendesse através das interações dos usuários da rede. Já era claro o que poderia acontecer, e aconteceu: a bot teve que ser desativada em menos de 24 horas, já que os usuários a tornaram absolutamente racista, transfóbica, misógina e por aí vai. Isso mostra o perigo da falta de baliza para nós mesmos.

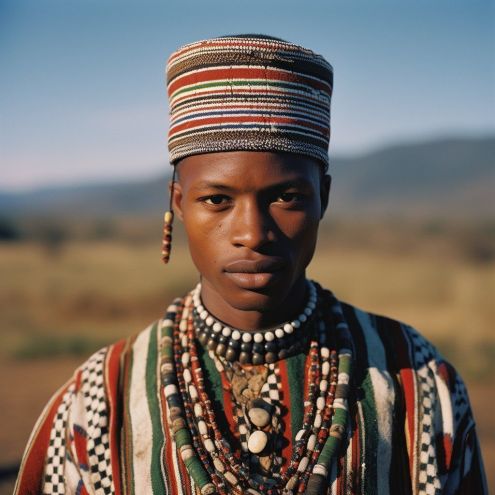

IA gera imagem estereotipada de pessoas de 30 países; veja fotos

-

1 de 30

1 de 30Estereótipo de uma ucraniana criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

2 de 30

2 de 30Estereótipo de uma taiwanesa criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

3 de 30

3 de 30Estereótipo de uma irlandesa criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

-

4 de 30

4 de 30Estereótipo de uma nigeriana criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

5 de 30

5 de 30Estereótipo de uma georgiana criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

6 de 30

6 de 30Estereótipo de uma jamaicano criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

-

7 de 30

7 de 30Estereótipo de uma islandesa criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

8 de 30

8 de 30Estereótipo de uma japonesa criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

9 de 30

9 de 30Estereótipo de uma francesa criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

-

10 de 30

10 de 30Estereótipo de uma egípcia criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

11 de 30

11 de 30Estereótipo de uma sul-coreana criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

12 de 30

12 de 30Estereótipo de uma colombiana criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

-

13 de 30

13 de 30Estereótipo de uma australiana criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

14 de 30

14 de 30Estereótipo de uma argentina criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

15 de 30

15 de 30Estereótipo de um português criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

-

16 de 30

16 de 30Estereótipo de uma angolana criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

17 de 30

17 de 30Estereótipo de uma tailandesa criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

18 de 30

18 de 30Estereótipo de uma russa criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

-

19 de 30

19 de 30Estereótipo de uma indonésia criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

20 de 30

20 de 30Estereótipo de uma mexicana criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

21 de 30

21 de 30Estereótipo de uma espanhola criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

-

22 de 30

22 de 30Estereótipo de um alemão criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

23 de 30

23 de 30Estereótipo de uma cazaque criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

24 de 30

24 de 30Estereótipo de um norte-americano criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

-

25 de 30

25 de 30Estereótipo de uma saudita criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

26 de 30

26 de 30Estereótipo de uma chinesa criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

27 de 30

27 de 30Estereótipo de um italiano criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

-

28 de 30

28 de 30Estereótipo de uma indiana criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

29 de 30

29 de 30Estereótipo de um sul-africano criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

30 de 30

30 de 30Estereótipo de uma brasileira criado pelo Midjourney, inteligência artificial geradora de imagens • Reprodução/Twitter

-

Mas como podemos influenciar, de fato, nisso?

Esse debate é longo e central quando se fala na “IA ética“. Ainda tenho dúvidas se isso poderia ser uma realidade, afinal não somos uma sociedade ética e não sei se conseguiremos vencer todos os nossos preconceitos e corrupções cotidianas, tais como o famoso “jeitinho brasileiro”, por exemplo, mas eu acredito que muito pode ser feito rapidamente, se realmente passarmos a discutir essas questões de forma aberta e ampla e partimos para ações efetivas de forma urgente, algo que realmente mexa com os poderosos (e sim, na maioria são homens) e que os impeça de perpetuar ferramentas e plataformas que corroborem com o que não é justo.

Isso envolve a adoção de uma série de abordagens interseccionais, sobre gênero, raça, etnia, estatuto socioeconômico e outros determinantes, além de adotar uma abordagem baseada nos direitos humanos para a governança da IA com base na transparência, responsabilização e dignidade humana. E isso já está sendo descrito há um tempo, por exemplo, com o que vem sendo denominado de “Ética by Design”, só não temos ações efetivas.

No geral, a escassez de mulheres na tecnologia gera problemas no design de muitos de seus produtos. Quando analisamos esses grandes modelos de IA (LLM) que tem em sua base de interação a conversação, como os chatbots, o Processamento de Linguagem Natural (NLP), que permite à máquina compreender e reproduzir a comunicação humana, percebemos que o NLP incorpora vieses de gênero. O mesmo acontece com os geradores de imagem e vídeos.

O que posso garantir é que induzir, no código, mudanças forçadas, pode ser catastrófico. É o que aconteceu recentemente com o Gemini do Google, no fim do mês passado, que teve sua geração de imagens interrompida, após apresentar erros raciais e históricos, como soldados negros na Alemanha em 1943, na era nazista. O Google tentou editar os resultados para serem menos estereotipados, justamente na tentativa de compensar a falta de diversidade nos seus dados de treinamento. Mas não deu certo.

Que estratégias são possíveis?

Pra além da governança, regulação e regulamentação necessária, podemos considerar três formas para a IA ser menos preconceituosa e enviesada. Já falei sobre eles, mas pra resumir temos: dados, algoritmos e pessoas.

O primeiro passo para superar preconceitos é garantir que os dados usados para treinar o sistema de IA sejam suficientemente enormes e diversos para representar a realidade.

Segundo é evitar que os algoritmos amplifiquem os possíveis vieses contidos nos dados. Podemos construir algoritmos para reduzir o preconceito, dizendo-lhes para ignorar certas informações, ou fazer com que o modelo use apenas certas informações para chegar ao resultado. Mas tudo isso requer estudo profundo.

Por exemplo, treinar o modelo para identificar quando ele está aprendendo um viés e impor alguma penalidade por isso, ou por fazer previsões incorretas, pode minimizar a forçação de barra como aconteceu com o Gemini. Além disso, há formas de reduzir a interpretação subjetiva dos dados, ao fazermos os algoritmos aprenderem a considerar apenas as variáveis que melhoram sua precisão preditiva, assim como melhorar a tomada de decisão mais justa.

Finalmente temos as pessoas que desenvolvem esses modelos, que têm seus objetivos, premissas e desejos. Embarcar os desenvolvedores em outras áreas pode também contribuir no processo, assim como envolver uma diversidade de especialistas na modelagem.

Independentemente disso, dados, algoritmos e pessoas se relacionam e no fim, é tudo pessoas e o que precisamos é questionar os preconceitos que temos em nós. Vai ser muito difícil chegar em uma IA completamente imparcial e justa, mas devemos minimizar os vieses ao máximo. Principalmente quando temos IAs que determinam resultados importantes, como por exemplo na área da saúde, na análise de crédito ou criminais.

E mais uma vez, isso deve incluir dinheiro. A grande maioria das plataformas usam dados disponíveis na internet e não pagam por eles. A Adobe, por exemplo, pagou fotógrafos para tirar milhares de fotos para formar a base de seu modelo gerador de imagem, o Firefly. Se os fotógrafos forem diversos e de muitas localidades e culturas, isso pode contribuir e minimizar os efeitos possíveis através de um tipo de controle viável.

Pra fechar o texto, mas não a reflexão, apesar dos preconceitos existirem, não podemos deixar eles se tornarem um aspecto inevitável das IAs. Quem sabe através dessas tecnologias possamos ir mudando, bem sutilmente e artificialmente, esses vieses que estão enraizados na nossa sociedade, e entender que o mundo é muito mais diversos do que nossas bolhas e do que tentam a História única.